Historia del hardware para niños

El hardware se refiere a todas las partes físicas de una computadora. Piensa en el hardware como el "cuerpo" de la computadora, mientras que el software es el "cerebro" o las instrucciones que le dicen al hardware qué hacer. Desde hace mucho tiempo, la humanidad ha necesitado herramientas para calcular y guardar información. Los primeros dispositivos de hardware eran muy sencillos, como palitos con marcas para contar objetos o el ábaco para hacer sumas y restas. Con el tiempo, estas herramientas evolucionaron hasta convertirse en las computadoras que conocemos hoy.

Plantilla:Ficha de historia de la computación

Contenido

- Los primeros pasos de la computación

- Primeras calculadoras mecánicas

- La era de las tarjetas perforadas

- Calculadoras de escritorio eléctricas

- Computadoras analógicas avanzadas

- Primeros computadores digitales

- La primera generación de computadoras (von Neumann)

- Segunda generación: La era de los transistores

- Tercera generación y más allá: Microchips y microprocesadores

- Galería de imágenes

- Véase también

Los primeros pasos de la computación

La necesidad de contar y calcular es muy antigua. Desde hace miles de años, las personas han usado diferentes objetos para ayudarse.

Herramientas antiguas para contar

- Palitos de cuenta: Probablemente fueron los primeros. Eran palitos con muescas para llevar un registro de cosas, como animales o cosechas.

- Tablillas de arcilla: En lugares como Fenicia, se usaban piezas de arcilla para registrar cantidades.

- Balanza: Aunque no es una calculadora, una balanza ayuda a establecer la igualdad de peso, lo que es una forma de comparación numérica.

El ábaco: Un invento milenario

El ábaco es una de las herramientas de cálculo más antiguas y conocidas. Se cree que la forma más primitiva, el ábaco de polvo, se inventó en Babilonia hace unos 2400 años antes de Cristo. En Egipto, se usaban ábacos de grano y alambre alrededor del año 501 a.C. El ábaco permitía sumar, restar y realizar cálculos más complejos moviendo cuentas en varillas o surcos.

Computadoras analógicas antiguas

En la Antigüedad y la Edad Media, se crearon máquinas especiales llamadas computadoras analógicas. Estas máquinas usaban movimientos mecánicos para resolver problemas de astronomía.

- Mecanismo de Anticitera: Un increíble dispositivo de la antigua Grecia (hace unos 150-100 a.C.) que predecía movimientos celestes.

- Planisferio y ecuatorio: Inventos de astrónomos persas y árabes como Al-Biruni y Azarquiel (alrededor del año 1000 d.C.) que también ayudaban en cálculos astronómicos.

Primeras calculadoras mecánicas

Con el tiempo, las personas buscaron formas más rápidas y precisas de calcular.

La regla de cálculo

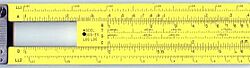

John Napier (1550-1617) descubrió que la multiplicación y la división se podían hacer sumando y restando logaritmos. Esto llevó a la invención de los huesos de Napier, un dispositivo para multiplicar y dividir. Más tarde, en los años 1620, se inventó la regla de cálculo. Esta herramienta permitía hacer multiplicaciones y divisiones mucho más rápido. Fue muy usada por ingenieros y científicos hasta que aparecieron las calculadoras de bolsillo.

Calculadoras mecánicas digitales

- Wilhelm Schickard (1623): Construyó la primera calculadora mecánica digital. Usaba engranajes, como los relojes, y por eso la llamó "reloj calculador".

- Blaise Pascal (1642): Creó la Pascalina, una máquina que podía sumar y restar.

- Gottfried Wilhelm von Leibniz (1671): Mejoró los diseños anteriores y también describió el sistema de numeración binario, que es fundamental para todas las computadoras modernas.

- Charles Xavier Thomas de Colmar (1820): Creó el Aritmómetro, la primera calculadora mecánica producida en masa que podía sumar, restar, multiplicar y dividir.

Estas calculadoras mecánicas se usaron hasta los años 1970.

La era de las tarjetas perforadas

Una gran innovación llegó con el uso de tarjetas perforadas para controlar máquinas.

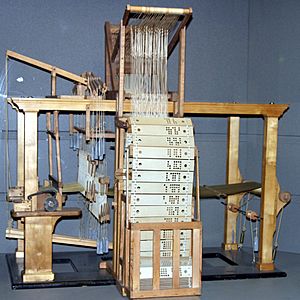

Telar de Jacquard

En 1801, Joseph Marie Jacquard desarrolló un telar donde el diseño de la tela se controlaba con tarjetas perforadas. Si se cambiaban las tarjetas, el telar tejía un patrón diferente sin necesidad de modificar la máquina. Esto fue un paso muy importante hacia la idea de la "programación".

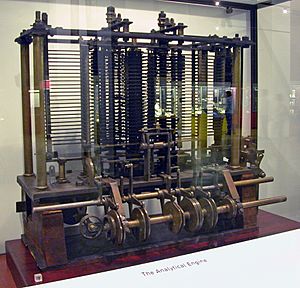

La máquina analítica de Charles Babbage

Charles Babbage (1833) diseñó la máquina analítica, una computadora programable de propósito general. Quería que usara tarjetas perforadas, como el telar de Jacquard, para introducir instrucciones y datos. Su idea era que una máquina pudiera calcular e imprimir tablas matemáticas con gran precisión. Aunque su diseño era muy avanzado, la tecnología de la época no permitía fabricar las piezas con la precisión necesaria, y el proyecto no se terminó.

Herman Hollerith y el censo

En 1890, la Oficina del Censo de los Estados Unidos usó tarjetas perforadas y máquinas tabuladoras diseñadas por Herman Hollerith para procesar los datos del censo. La compañía de Hollerith se convirtió más tarde en el núcleo de IBM. Las tarjetas perforadas se hicieron muy comunes en la industria y el gobierno hasta los años 1970.

Calculadoras de escritorio eléctricas

A principios del siglo XX, las calculadoras mecánicas empezaron a usar motores eléctricos.

La evolución de las calculadoras de escritorio

Desde los años 1930, empresas como Friden y Monroe fabricaron calculadoras mecánicas de escritorio que podían sumar, restar, multiplicar y dividir. La palabra "computador" se usaba para referirse a las personas que hacían cálculos con estas máquinas.

En 1948, apareció la Curta, una calculadora mecánica pequeña y portátil. Pero el verdadero cambio llegó con las calculadoras electrónicas. La primera calculadora de escritorio completamente electrónica fue la ANITA Mk.VII británica (1961), que usaba tubos de vacío. Luego, en 1963, Friden lanzó la EC-130, que ya usaba transistores.

Con la invención de los circuitos integrados y los microprocesadores, las calculadoras se hicieron mucho más pequeñas y económicas.

Computadoras analógicas avanzadas

Antes de la Segunda Guerra Mundial, las computadoras analógicas mecánicas y eléctricas eran muy importantes.

¿Cómo funcionaban?

Estas computadoras aprovechaban que las matemáticas de ciertos fenómenos físicos (como el movimiento de ruedas o el voltaje eléctrico) son similares a las matemáticas de otros fenómenos (como la trayectoria de un proyectil). Así, podían crear "análogos" eléctricos de sistemas complejos para predecir su comportamiento. Por ejemplo, se usaron para controlar armas, como los sistemas de lanzamiento de torpedos.

A diferencia de las computadoras digitales modernas, las analógicas no eran muy flexibles. Había que reconfigurarlas manualmente para cada problema. Sin embargo, eran muy útiles para resolver ecuaciones complejas que las primeras computadoras digitales no podían manejar. Con el tiempo, las computadoras digitales se hicieron más rápidas y con más memoria, y casi reemplazaron por completo a las analógicas.

Primeros computadores digitales

La era de la computadora moderna comenzó con un gran avance antes y durante la Segunda Guerra Mundial. Los componentes mecánicos fueron reemplazados por circuitos electrónicos, relés, condensadores y tubos de vacío.

Hacia la computación universal

- Máquina de Turing: En 1936, Alan Turing describió una máquina teórica, la "máquina de Turing", que podía realizar cualquier cálculo. Las computadoras modernas son "Turing completo", lo que significa que pueden hacer cualquier cálculo que una máquina de Turing pueda hacer.

- Arquitectura de von Neumann: Para que una computadora fuera realmente útil, necesitaba una forma de guardar tanto los programas como los datos en la misma memoria. Esta idea, conocida como la arquitectura de von Neumann, es la base de casi todas las computadoras actuales.

Desarrollos importantes

Durante la Segunda Guerra Mundial, hubo varios proyectos de computadoras digitales:

La serie Z de Konrad Zuse

En Alemania, Konrad Zuse construyó sus primeras calculadoras de la serie Z.

- Z1 (1938): Era mecánica y binaria, pero no funcionaba bien por la falta de precisión de las piezas.

- Z3 (1941): Usaba relés telefónicos y funcionó correctamente. Fue la primera computadora funcional, de propósito general y controlada por un programa. Usaba el sistema binario, lo que la hacía más fácil de construir que los diseños decimales de Babbage. Los programas se introducían con películas perforadas.

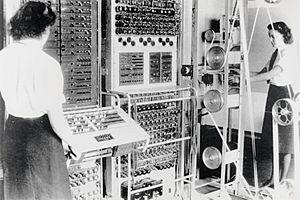

Colossus

Durante la Segunda Guerra Mundial, los británicos en Bletchley Park usaron máquinas para descifrar mensajes alemanes.

- Bombes: Máquinas electromecánicas diseñadas por Alan Turing para descifrar mensajes de la máquina Enigma.

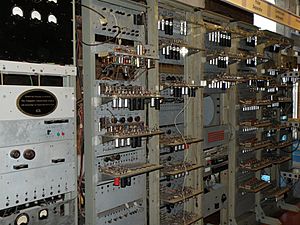

- Colossus (1943): Fue el primer dispositivo de computación totalmente electrónico. Usaba muchos tubos de vacío y entrada de cinta de papel. Se usó para descifrar mensajes alemanes complejos. Su existencia se mantuvo en secreto hasta los años 1970.

Desarrollos en Norteamérica

- Claude Shannon (1937): Su tesis en el MIT mostró cómo usar el álgebra booleana con relés y conmutadores electrónicos, sentando las bases del diseño de circuitos digitales.

- George Stibitz (1937): En los Laboratorios Bell, construyó el "Modelo K", una computadora basada en relés que calculaba con adición binaria. En 1940, demostró que se podían enviar comandos a una computadora a distancia usando líneas telefónicas.

- Atanasoff-Berry Computer (ABC) (1939): Desarrollado por John Vincent Atanasoff y Clifford Berry en la Iowa State University. Fue una calculadora electrónica digital para resolver ecuaciones. Usaba tubos de vacío y condensadores para la memoria. No era programable, pero fue la primera en usar circuitos electrónicos.

- Harvard Mark I (1939): Construida por Howard Aiken con financiamiento de IBM. Era una computadora electromecánica de propósito general, influenciada por el diseño de Babbage. Se programaba con cinta de papel perforado.

ENIAC

El ENIAC (Electronic Numerical Integrator and Computer) fue el primer computador electrónico de propósito general, construido en Estados Unidos entre 1943 y 1945. Era 1000 veces más rápido que las máquinas de su tiempo. Aunque muchos pensaban que sus miles de tubos de vacío se quemarían a menudo, funcionaba por horas sin fallar. Esto demostró que la electrónica era viable para la computación a gran escala. Al principio, programar el ENIAC significaba volver a cablearlo, pero luego se mejoró para usar programas almacenados en paneles de interruptores.

La primera generación de computadoras (von Neumann)

Antes de que el ENIAC estuviera terminado, sus creadores, Eckert y Mauchly, ya pensaban en una nueva computadora con "programa almacenado", el EDVAC. John von Neumann describió este diseño, donde tanto los programas como los datos se guardaban en la misma memoria. Esta idea, la arquitectura de von Neumann, es la base de las computadoras digitales modernas.

Tipos de memoria temprana

- Líneas de retardo acústico: Usaban el tiempo que tardaba el sonido en viajar por un medio (como mercurio líquido) para almacenar datos temporalmente.

- Tubos de Williams: Usaban la capacidad de una pantalla de televisión para guardar y recuperar datos.

- Memoria de núcleo magnético: A partir de 1954, esta memoria se hizo muy popular y dominó hasta mediados de los años 1970.

Primeras máquinas con arquitectura von Neumann

- Manchester "Baby" (1948): La primera máquina funcional con arquitectura von Neumann, construida en la universidad de Mánchester.

- Manchester Mark I (1949): Una versión completa del "Baby", que usaba tubos de Williams y tambores magnéticos para la memoria.

- EDSAC (1949): Diseñado y construido en la Universidad de Cambridge, también fue una de las primeras computadoras con programa almacenado y podía resolver problemas reales.

- MESM (1950): La primera computadora programable universal en la Unión Soviética.

- CSIRAC (1949): Un diseño australiano, la computadora más antigua que aún existe y la primera en reproducir música digital.

- LEO I (1951): Construida por J. Lyons & Company en el Reino Unido, fue la primera en realizar tareas de oficina rutinarias.

- UNIVAC I (1951): La primera computadora "producida en masa", vendida a la Oficina del Censo de EE. UU. Usaba tubos de vacío y líneas de retardo de mercurio.

- IBM 701 (1952): La primera de la exitosa serie de computadoras grandes de IBM.

- IBM 650 (1954): Una computadora más pequeña y económica de IBM que se hizo muy popular.

Segunda generación: La era de los transistores

A finales de los años 1950, un gran cambio llegó con la sustitución de los tubos de vacío por los transistores.

Ventajas de los transistores

Los transistores fueron inventados en 1948 por John Bardeen, Walter Brattain y William Shockley (ganadores del Premio Nobel de Física en 1956). Son dispositivos electrónicos hechos de materiales como el silicio.

- Más pequeños: Un transistor mide solo unos milímetros, mucho menos que un tubo de vacío.

- Más rápidos: Pueden cambiar de estado (de 1 a 0) en millonésimas de segundo.

- Más económicos: Su fabricación es más barata.

- Más confiables: Trabajan "en frío", lo que evita las fallas por calentamiento de los tubos de vacío.

Gracias a los transistores, las computadoras se hicieron más rápidas, económicas y confiables. Esto permitió construir máquinas con decenas de miles de circuitos complejos en un espacio reducido.

Computadoras de segunda generación

- IBM 1401: Fue muy popular entre 1960 y 1964, monopolizando gran parte del mercado mundial.

- ELEA de Olivetti: Un intento italiano de crear computadoras en este período.

En esta época, las memorias de disco podían almacenar millones de caracteres, y se podían conectar varias unidades a una misma computadora. También surgieron las unidades terminales para transmitir datos a la computadora central a distancia, usando conexiones telefónicas.

Tercera generación y más allá: Microchips y microprocesadores

La verdadera explosión en el uso de computadoras comenzó con la "tercera generación", gracias a la invención del circuito integrado (o microchip) por Jack St. Clair Kilby y Robert Noyce. Esto llevó a la invención del microprocesador por Ted Hoff y Federico Faggin en Intel.

El impacto del microprocesador

El microprocesador hizo posible el desarrollo del microcomputador: computadoras pequeñas y de bajo costo que podían ser compradas por personas y pequeñas empresas.

- Los primeros microcomputadores aparecieron en los años 1970.

- Se hicieron muy comunes en los años 1980 y en adelante.

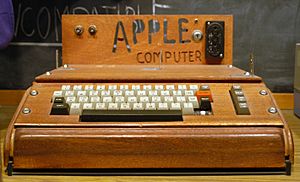

- Steve Wozniak, cofundador de Apple Computer, es conocido por desarrollar una de las primeras computadoras personales comercializadas masivamente, el Apple I.

Desde entonces, la computación ha avanzado a pasos agigantados, con computadoras cada vez más potentes y pequeñas, dominando casi todos los aspectos de nuestra vida.

Galería de imágenes

-

Los engranajes están en el corazón de dispositivos mecánicos como la calculadora de Curta.

-

Una reproducción de la computadora Z1 de Zuse.

Véase también

En inglés: History of computing hardware Facts for Kids

En inglés: History of computing hardware Facts for Kids

- Arquitectura de computadoras

- Computadora central

- Historia de Internet

- Historia de los computadores personales

- Historia de los sistemas operativos

- Historia del hardware de computador (1960-presente)

- Microcomputadora

- Minicomputadora

- Nanotecnología

- Anexo:Cronología de los lenguajes de programación

- Wikilibro de Montaje y Mantenimiento de Equipos Informáticos