Entropía para niños

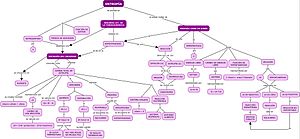

En termodinámica, la entropía (simbolizada como S) es una magnitud física que nos ayuda a entender el nivel de desorden o aleatoriedad en un sistema termodinámico. Imagina que mide cuántas formas diferentes pueden organizarse las pequeñas partes de un sistema sin que cambie su apariencia general. También podemos decir que mide la energía que no se puede usar para hacer un trabajo útil.

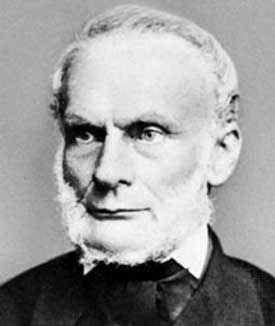

La entropía es una característica del estado de un sistema. En un sistema aislado, su valor siempre aumenta cuando ocurren procesos naturales. La entropía nos ayuda a entender por qué algunos procesos son irreversibles, es decir, por qué no pueden volver atrás por sí solos. La palabra "entropía" viene del griego y significa "transformación". Rudolf Clausius le dio este nombre en la década de 1850, y Ludwig Boltzmann la explicó matemáticamente en 1877, usando ideas de probabilidad.

Contenido

¿Por qué las cosas cambian de una forma y no de otra?

Cuando nos preguntamos por qué los eventos en la naturaleza suceden de una manera específica, la entropía nos da una pista. Por ejemplo, si pones en contacto dos objetos de metal, uno caliente y otro frío, sabes que el caliente se enfriará y el frío se calentará hasta que ambos tengan la misma temperatura. Lo contrario, que el objeto caliente se caliente más y el frío se enfríe más, es muy poco probable, aunque la energía total se mantenga igual.

El universo tiende a distribuir la energía de manera uniforme. Esto significa que busca maximizar la entropía. Intuitivamente, la entropía es una medida de la energía que no se puede convertir en trabajo.

La entropía es clave para entender el segundo principio de la termodinámica. Puedes pensar en ella como una medida de cuán "mezclado" o "desordenado" está un sistema. Un sistema muy desordenado tiene una entropía alta. Un sistema que está en una condición poco probable (muy ordenada) tenderá a reorganizarse hacia una condición más probable (más desordenada). Esta reorganización aumenta la entropía. La entropía alcanza su punto máximo cuando el sistema llega al equilibrio, que es la configuración más probable.

Una característica importante de la entropía es que su cambio entre dos estados de un sistema no depende de cómo se llegó de un estado al otro. Esto es fundamental para calcular cómo varía la entropía.

La variación de entropía nos muestra cómo cambia el orden de las moléculas en una reacción química. Si la entropía aumenta, los productos de la reacción están más desordenados que los reactivos. Si disminuye, los productos son más ordenados. La relación entre la entropía y si una reacción ocurre de forma espontánea se explica con la energía libre de Gibbs.

Entropía y la Termodinámica

La RAE define la entropía como una "magnitud termodinámica que mide la parte de la energía no utilizable para realizar trabajo". Se calcula dividiendo el calor que un cuerpo cede entre su temperatura absoluta.

Dentro de la Termodinámica, que es la rama de la física que estudia cómo se intercambia la energía, la entropía representa el desorden. Nos muestra que cuando algo no está controlado, puede transformarse y desordenarse. La entropía también sugiere que de ese desorden en un sistema puede surgir una nueva situación de equilibrio, donde las partes están igualadas o equilibradas, aunque sea diferente del estado inicial.

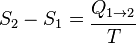

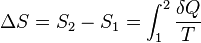

Esta idea del desorden termodinámico fue expresada por Rudolf Clausius con una fórmula. Para un proceso donde el sistema vuelve a su estado original (un proceso reversible), el cambio en la entropía (ΔS) entre dos estados se calcula así:

.

.

Aquí, δQ es la cantidad de calor que se absorbe y T es la temperatura absoluta (en Kelvin).

De forma más sencilla, si la temperatura no cambia (en un proceso isotérmico):

Donde S2 es la entropía final, S1 es la entropía inicial,  es el calor intercambiado y T es la temperatura absoluta.

es el calor intercambiado y T es la temperatura absoluta.

La unidad de entropía en el Sistema Internacional es el Julio por Kelvin (J/K).

¿Qué significa esto?

Significa que cuando un sistema cambia de un estado a otro de forma reversible y sin cambio de temperatura, el cambio en su entropía es igual al calor que intercambia con el ambiente, dividido por su temperatura absoluta.

Si el sistema recibe calor, su entropía aumenta. Si la temperatura es más alta, el mismo flujo de calor causa un aumento de entropía.

La unidad J/K se define como el cambio de entropía que experimenta un sistema cuando absorbe 1 julio de calor a una temperatura de 1 kelvin.

Cuando un sistema evoluciona de forma irreversible (como la mayoría de los procesos reales), la entropía total del universo siempre aumenta.

Si un proceso es reversible y no hay intercambio de calor (se llama adiabático), la entropía no cambia, es decir, es constante. Esto se conoce como un proceso isoentrópico.

El Cero Absoluto

Solo podemos calcular los cambios de entropía. Para saber la entropía de un sistema, necesitamos un punto de partida. El tercer principio de la termodinámica establece que para sustancias puras y perfectas, la entropía es cero en el cero absoluto (0 K o -273.15 °C). En este punto, las partículas están en su estado más ordenado posible.

La entropía nos ayuda a entender el segundo principio de la termodinámica, que dice que los procesos tienden a ocurrir en una sola dirección. Por ejemplo, un vaso de agua no empieza a hervir por un lado y a congelarse por el otro de forma espontánea, aunque la energía total se conserve (esto lo explica el primer principio de la termodinámica).

Entropía y la Reversibilidad

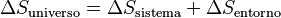

La entropía total de un proceso incluye la entropía del sistema y la de sus alrededores. Se puede decir que el cambio de entropía del universo es la suma del cambio de entropía del sistema y el cambio de entropía del entorno:

Si un proceso fuera perfectamente reversible, el cambio de entropía del universo sería cero. Esto significaría que el calor que el sistema absorbe o libera es igual al trabajo que realiza. Pero esto es una situación ideal que no ocurre en la naturaleza, ya que los procesos reales siempre tienen pérdidas (por ejemplo, por fricción) y son irreversibles.

Como los procesos reales siempre son irreversibles, la entropía total siempre aumenta. Así como la energía no se crea ni se destruye, la entropía puede crearse pero no destruirse. Por lo tanto, podemos decir que, como el universo es un sistema aislado, su entropía crece constantemente con el tiempo. Esto nos da una idea de cómo evoluciona el mundo físico, conocido como el principio de evolución.

Cuando la entropía del universo sea máxima, es decir, cuando haya un equilibrio total de temperaturas y presiones, se llegará a la muerte térmica del universo (una idea propuesta por Clausius).

En sistemas muy pequeños, del tamaño de las moléculas, la diferencia entre calor y trabajo desaparece, y conceptos como la entropía o la temperatura pierden su significado. Por eso, el segundo principio de la termodinámica no se aplica a estos microsistemas. También se cree que hay un límite superior para la aplicación de este principio, lo que pone en duda la idea de Clausius sobre la muerte térmica del universo.

Historia de la Entropía

La idea de la entropía surgió al observar que una parte de la energía liberada en las reacciones de combustión siempre se perdía debido a la disipación o la fricción, y no se convertía en trabajo útil. Los primeros motores de calor, como los de Thomas Savery (1698) o la máquina de Newcomen (1712), eran muy poco eficientes. Convertían menos del 2% de la energía en trabajo útil; una gran cantidad de energía se perdía en lo que parecía un estado de desorden inmenso. Durante los siguientes dos siglos, los científicos investigaron esta energía perdida, y el resultado fue el concepto de entropía.

En la década de 1850, Rudolf Clausius definió el concepto de sistema termodinámico y propuso que, en cualquier proceso irreversible, una pequeña cantidad de energía térmica se disipa gradualmente. Clausius siguió desarrollando sus ideas sobre la energía perdida y acuñó el término "entropía". El concepto se desarrolló aún más durante el siguiente medio siglo. Más recientemente, la entropía también se ha aplicado para entender la pérdida de información en los sistemas de transmisión de datos.

Más para Explorar

Véase también

En inglés: Entropy Facts for Kids

En inglés: Entropy Facts for Kids