Internet profunda para niños

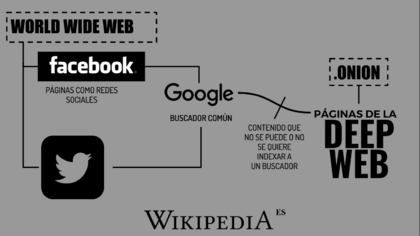

La Internet profunda (también conocida como deep web, internet invisible o internet oculta) se refiere a todo el contenido de internet que los motores de búsqueda comunes, como Google o Bing, no pueden encontrar ni organizar en sus listas. Esto sucede por varias razones. El informático Mike Bergman fue quien usó por primera vez el término "internet profunda".

Contenido

¿Por qué existe la Internet Profunda?

La razón principal de la existencia de la internet profunda es que los motores de búsqueda no pueden encontrar o clasificar una gran parte de la información que hay en internet. Si los buscadores pudieran acceder a toda la información, la internet profunda sería mucho más pequeña.

Sin embargo, incluso si los motores de búsqueda pudieran clasificar toda la información, la internet profunda seguiría existiendo. Esto se debe a que siempre habrá páginas privadas. Los motores de búsqueda no pueden acceder a la información de estas páginas, y solo las personas con contraseñas o códigos especiales pueden verlas.

Los motores de búsqueda no pueden clasificar algunas páginas por los siguientes motivos:

- Documentos o información oculta: Son archivos que no están en las páginas que los buscadores ya tienen registradas.

- Contenido que cambia: Son páginas cuyo contenido varía según el contexto, como la ubicación del usuario o sus visitas anteriores.

- Contenido dinámico: Son páginas que se generan como respuesta a lo que el usuario escribe, por ejemplo, al llenar un formulario.

- Contenido con acceso restringido: Son páginas protegidas con contraseña o con un Captcha (un sistema para verificar que eres una persona y no un robot).

- Contenido que no es HTML: Es texto que está dentro de archivos multimedia (como videos o imágenes) o en otros tipos de archivos como .exe, .rar o .zip.

- Programas especiales: Es contenido que está oculto a propósito y que necesita un programa o protocolo específico para poder acceder a él. Algunos ejemplos son Tor, I2P o Freenet.

- Páginas sin enlaces: Son páginas que no tienen enlaces desde otras páginas, por lo que los buscadores no saben que existen.

La internet profunda no es un lugar prohibido o misterioso de internet. Tampoco es una tecnología necesariamente peligrosa o ilegal. En ella se encuentran muchos tipos de recursos a los que es difícil acceder con los métodos comunes, como los motores de búsqueda populares. Una parte de la internet profunda incluye las redes internas de instituciones científicas y académicas, que se conoce como la Internet Académica Invisible. Esta parte contiene bases de datos con avances tecnológicos, publicaciones científicas y material educativo en general, a los que no se puede acceder fácilmente.

¿Quién le dio su nombre?

El informático Mike Bergman, en un artículo sobre la internet profunda, mencionó que Jill Ellsworth usó el término "Web invisible" en 1994. Ella lo usó para referirse a los sitios web que no estaban registrados por ningún motor de búsqueda.

En su artículo, Bergman citó una entrevista de 1996 donde Ellsworth explicó: "Sería un sitio que, posiblemente, esté diseñado razonablemente, pero no se molestaron en registrarlo en alguno de los motores de búsqueda. ¡Por lo tanto, nadie puede encontrarlos! Estás oculto. Yo llamo a esto la Web invisible."

Otros que usaron el término "Web Invisible" o "web profunda" al principio fueron Bruce Monte y Matthew B. Koll de Personal Library Software, en un comunicado de prensa de 1996.

El uso específico del término "web profunda", como lo conocemos hoy, apareció por primera vez en el estudio de Bergman de 2001.

Algunas personas dicen que el término "web invisible" no es del todo exacto porque:

- Muchos usuarios creen que la única forma de acceder a la web es usando un buscador.

- Parte de la información es más fácil de encontrar que otra, pero eso no significa que sea invisible.

- La web tiene información de muchos tipos que se guarda y se recupera de diferentes maneras.

- El contenido que los buscadores clasifican también se guarda en bases de datos y solo está disponible cuando el usuario lo pide. Por eso, no es correcto decir que la información guardada en bases de datos es invisible.

¿Qué tan grande es la Internet Profunda?

La internet profunda es un conjunto de sitios web y bases de datos que los buscadores comunes no pueden encontrar porque no están clasificados. El contenido que se puede encontrar en la internet profunda es muy variado y extenso.

Internet se divide en dos partes: la internet profunda y la superficial. La internet superficial está formada por páginas que los motores de búsqueda pueden entender y clasificar fácilmente. En cambio, la internet profunda tiene páginas cuyos nombres de dominio están codificados de una manera especial. Estas páginas se muestran de forma particular y no necesitan registrarse. Para verlas, tu computadora necesita un servicio especial que funciona como un sistema de nombres de dominio, pero para las páginas de la internet profunda.

Mientras que las páginas normales se identifican con un protocolo estándar, las páginas de la internet profunda se repiten a través de la red a la que se conecta un navegador especializado. El sistema para encontrar contenido es similar al que usa BitTorrent: la información se guarda en una base de datos y solo se entrega cuando el usuario la solicita.

En 2010, se calculó que la información en la internet profunda era de 7500 terabytes, lo que equivale a unos 550 billones de documentos individuales. En comparación, se estimó que la internet superficial contenía solo 19 terabytes de contenido y un billón de documentos individuales.

También en 2010, se calculó que había más de 200 000 sitios en la internet profunda.

Estimaciones de un estudio de la Universidad de California en Berkeley sugieren que la internet profunda podría tener actualmente unos 91 000 terabytes.

La Association for Computing Machinery (ACM) publicó en 2007 que Google y Yahoo clasificaban el 32% de los elementos de la internet profunda, y MSN tenía la menor cobertura con el 11%. Sin embargo, la cobertura total de los tres motores era del 37%, lo que indicaba que clasificaban casi los mismos elementos.

Internet Académica Invisible

La Internet Académica Invisible (o Academic Invisible Web, AIW) es el conjunto de bases de datos y colecciones importantes para el mundo académico que los motores de búsqueda comunes no pueden encontrar. La preocupación es que millones de documentos permanecen ocultos para los usuarios normales. Estos documentos pueden incluir artículos, libros, informes, documentos de acceso abierto y datos de encuestas, entre otros. El problema con los motores de búsqueda comunes es que no muestran datos que cambian constantemente, como información del clima o imágenes de satélite. Esta información cambia tan rápido que es imposible de clasificar, lo que impide que aparezca en los buscadores tradicionales.

Una forma de empezar a clasificar y hacer más accesible la Internet Académica Invisible son los motores de búsqueda que se enfocan en información académica, como Google Scholar o Scirus. El problema con estos buscadores es que fueron creados por empresas comerciales. El portal de ciencia Vascoda ha demostrado ser una alternativa efectiva para conectar la Internet académica visible e invisible. Este portal integra bases de datos de literatura, colecciones de bibliotecas y otros contenidos académicos usando un sistema de clasificación basado en las etiquetas de cada dominio que contiene la información.

Es importante mencionar que no toda la ausencia de esta información en la Internet Visible se debe a los motores de búsqueda. Otro factor es que algunos de estos documentos son propiedad de editoriales de bases de datos.

Tamaño de la Internet Académica Invisible

El intento más preciso de medir la cantidad de documentos académicos en la web invisible fue realizado por Bergman en 2001 en su estudio The Deep Web: Surfacing Hidden Value. En esta investigación, Bergman hizo una lista de los 60 sitios académicos más grandes de la internet profunda. Entre ellos estaban el National Climatic Data Center (NOAA), NASA EOSDIS y el National Oceanographic (combined with Geophysical) Data Center (NOAA).

| Nombre | Tipo | Tamaño (GBs) |

|---|---|---|

| National Climatic Data Center (NOAA) | Público | 366,000 |

| NASA EOSDIS | Público | 219,600 |

| National Oceanographic (combined with Geophysical) Data Center (NOAA) | Público/Pago | 32,940 |

| DBT Online | Pago | 30,500 |

| Alexa | Público (parcial) | 15,860 |

| Right-to-Know Network (RTK Net) | Público | 14,640 |

| Lexis-Nexis | Pago | 12,200 |

| Dialog | Pago | 10,980 |

| Genealogy - ancestry.com | Pago | 6,500 |

| MP3.com | Público | 4,300 |

| Terraserver | Público/Pago | 4,270 |

| ProQuest Direct (incl. Digital Vault) | Pago | 3,172 |

| Dun & Bradstreet | Pago | 3,113 |

| Westlaw | Pago | 2,684 |

| Dow Jones News Retrieval | Pago | 2,684 |

| HEASARC (High Energy Astrophysics Science Archive Research Center) | Público | 2,562 |

| US PTO - Trademarks + Patents | Público | 2,440 |

| Informedia (Carnegie Mellon Univ.) | Público | 1,830 |

| infoUSA | Pago/Público | 1,584 |

| Alexandria Digital Library | Público | 1,220 |

| JSTOR Project | Limitado | 1,220 |

| 10K Search Wizard | Público | 769 |

| UC Berkeley Digital Library Project | Público | 766 |

| SEC Edgar | Público | 610 |

| US Census | Público | 610 |

| Elsevier Press | Pago | 570 |

| NCI CancerNet Database | Público | 488 |

| EBSCO | Pago | 481 |

| Amazon.com | Público | 461 |

| IBM Patent Center | Público/Privado | 345 |

| NASA Image Exchange | Público | 337 |

| Springer-Verlag | Pago | 221 |

| InfoUSA.com | Público/Privado | 195 |

| OVID Technologies | Pago | 191 |

| Investext | Pago | 157 |

| Blackwell Science | Pago | 146 |

| Betterwhois (muchos similares) | Público | 152 |

| GPO Access | Público | 146 |

| Adobe PDF Search | Público | 143 |

| Internet Auction List | Público | 130 |

| Commerce, Inc. | Público | 122 |

| Library of Congress Online Catalog | Público | 116 |

| GenServ | Pago | 106 |

| Academic Press IDEAL | Pago | 104 |

| Sunsite Europe | Público | 98 |

| Uncover Periodical DB | Público/Pago | 97 |

| Astronomer's Bazaar | Público | 94 |

| eBay.com | Público | 82 |

| Tradecompass | Pago | 61 |

| REALTOR.com Real Estate Search | Público | 60 |

| Federal Express | Público | 53 |

| Integrum | Público/Privado | 49 |

| NIH PubMed | Público | 41 |

| Visual Woman (NIH) | Público | 40 |

| AutoTrader.com | Público | 39 |

| UPS | Público | 33 |

| NIH GenBank | Público | 31 |

| AustLi (Australasian Legal Information Institute) | Público | 24 |

| Digital Library Program (UVa) | Público | 21 |

| INSPEC | Pago | 16 |

| Subtotal fuentes públicas y mixtas | 673,035 | |

| Subtotal fuentes pagas | 75.469 | |

| TOTAL | 748,504 |

El problema con esta medición es que se hizo por el tamaño de la página (en GB) y no por la cantidad de artículos publicados. Sin embargo, esta cantidad mostraba que había más de 700 TB (700 000 GB) de información que no está expuesta en la Internet superficial.

Esta información se complementa con datos de Lewandosky, quien comparó los datos de Bergman con los del Gale Directory of Databases. En este directorio se calculó que existe un total de 18.92 billones de documentos académicos en total.

¿Cómo se explora la Internet Profunda?

Los motores de búsqueda comerciales han empezado a buscar formas diferentes de explorar la internet profunda. El Protocolo del sitio (creado por Google en 2005) y OAI son sistemas que permiten a los motores de búsqueda encontrar recursos de la internet profunda en servidores web específicos. Ambos sistemas permiten que los servidores web anuncien las direcciones URL a las que se puede acceder, lo que ayuda a encontrar automáticamente recursos que no están directamente conectados a la web superficial. El sistema de búsqueda de la internet profunda de Google calcula previamente las respuestas de cada formulario HTML y añade las páginas HTML resultantes al índice del motor de búsqueda de Google. Este sistema ha logrado responder a mil consultas por segundo sobre el contenido de la internet profunda. Este sistema usa tres algoritmos clave:

- Elegir los valores de entrada, para que las búsquedas de texto acepten palabras clave.

- Identificar las entradas que solo aceptan valores específicos (como una fecha).

- Seleccionar un pequeño número de combinaciones de entrada que generen URLs adecuadas para incluir en el índice de búsqueda.

Las arañas (web crawlers)

Cuando usas un buscador y haces una pregunta, el buscador no recorre todo internet para encontrar las respuestas. En cambio, busca en su propia base de datos, que ya ha sido creada y organizada. Se usan programas llamados "arañas web" (o web crawlers) o robots (conocidos como "bots") que buscan información saltando de una página web a otra siguiendo los enlaces y registrando lo que encuentran.

El contenido de la internet profunda rara vez aparece en los resultados de los motores de búsqueda, porque las "arañas" no exploran bases de datos ni extraen su contenido. Las arañas no pueden acceder a páginas protegidas con contraseñas. Algunos desarrolladores que no quieren que sus páginas sean encontradas ponen etiquetas especiales en el código para evitar que sean clasificadas. Las "arañas" tampoco pueden mostrar páginas que no estén hechas en lenguaje HTML, ni pueden leer enlaces que incluyen un signo de interrogación. Sin embargo, ahora algunos motores de búsqueda más avanzados están clasificando sitios web que no están creados con HTML o que tienen signos de interrogación. Aun así, se calcula que incluso con estos buscadores avanzados, solo se logra acceder al 16% de la información disponible en la internet profunda. Existen diferentes técnicas de búsqueda para extraer contenido de la internet profunda, como usar librerías de bases de datos o simplemente conocer la URL a la que quieres acceder y escribirla manualmente.

Tor

The Onion Router (abreviado como TOR) es un proyecto creado por la marina de los Estados Unidos y lanzado el 20 de septiembre de 2002. Después, fue apoyado por la EFF (Electronic Frontier Foundation, una organización que defiende los derechos digitales). Actualmente (2022), sigue existiendo como The Tor Project, una organización sin ánimo de lucro que fue premiada en 2011 por la Free Software Foundation. Este premio se le dio por permitir que millones de personas en el mundo tengan libertad de acceso y expresión en internet, manteniendo su privacidad y anonimato.

A diferencia de los navegadores de internet comunes, Tor permite a los usuarios navegar por la web de forma anónima. Tor se descarga entre 30 y 50 millones de veces al año, tiene 0.8 millones de usuarios diarios y un aumento del 20% solo en 2013. Tor puede acceder a unos 6500 sitios web ocultos.

Cuando usas el programa Tor para acceder a la internet profunda, los datos de tu computadora se protegen en capas. El programa envía los datos a través de una red de conexiones a otras computadoras (llamadas "nodos" o relays). Cada nodo quita una capa de protección antes de reenviar los datos. Esta ruta cambia con frecuencia. Tor tiene más de 4000 nodos, y todos los datos protegidos pasan por al menos tres de ellos. Una vez que el último nodo quita la última capa de protección, te conecta a la página web que quieres visitar.

El contenido que se puede encontrar en la internet profunda es muy amplio. Por ejemplo, hay datos que se actualizan en tiempo real, como los valores de la bolsa, información del tiempo o los horarios de trenes. También hay bases de datos de agencias de investigación y material académico.

Criptomoneda

Es posible encontrar sitios web que usan monedas digitales como el Bitcoin para realizar transacciones. Estas monedas se intercambian entre el usuario y el vendedor a través de billeteras digitales, lo que hace que sean muy difíciles de rastrear.

Es importante saber que, aunque existen algunos mercados específicos, gran parte del comercio en la internet profunda puede incluir ofertas engañosas y fraudes. En los últimos años, se ha demostrado que Bitcoin no es una criptomoneda completamente segura en cuanto a la confidencialidad de los datos de sus usuarios. Por esta razón, no tendría mucho sentido usarla en redes que buscan el anonimato, como Tor, Freenet o I2P, cuyos usuarios intentan lograr la máxima privacidad.

Tipos de recursos en la Internet Profunda

Los recursos de la internet profunda se pueden clasificar en las siguientes categorías:

- Contenido de acceso limitado: Son sitios que restringen el acceso a sus páginas de forma técnica. Por ejemplo, usan el estándar de exclusión de robots o captcha, que impiden que los motores de búsqueda las exploren y guarden copias.

- Contenido dinámico: Son páginas que muestran una respuesta a una pregunta o a un formulario, especialmente si usan campos de texto abiertos.

- Contenido no enlazado: Son páginas que no están conectadas con otras páginas. Esto puede impedir que los programas de rastreo web accedan a su contenido. Este material se conoce como páginas sin enlaces de entrada.

- Contenido programado: Son páginas a las que solo se puede acceder a través de enlaces creados con JavaScript, o contenido que se descarga de forma dinámica desde servidores web usando soluciones de Flash o Ajax.

- Sin contenido HTML: Es texto que está dentro de archivos multimedia (imagen o video) o en formatos de archivo específicos que los motores de búsqueda no procesan.

- Web privada: Son sitios que requieren un registro y una contraseña para iniciar sesión.

- Web contextual: Son páginas con contenidos diferentes según el contexto de acceso (por ejemplo, la ubicación del usuario o la secuencia de navegación anterior).

Véase también

En inglés: Deep Web Facts for Kids

En inglés: Deep Web Facts for Kids