Historia de las ciencias de la computación para niños

La historia de la computación es el relato de cómo las personas han inventado herramientas para ayudarse a calcular y procesar información a lo largo del tiempo. Desde los primeros métodos sencillos hasta las complejas computadoras modernas, este campo ha crecido mucho, pasando de ser una parte de las matemáticas a convertirse en una ciencia propia y una industria global.

Contenido

Primeros Pasos en el Cálculo

Una de las primeras herramientas para calcular fue el ábaco, que se usó en Sumeria hace más de 4700 años. El ábaco sumerio era una tabla con columnas que representaban diferentes valores numéricos. Hoy en día, todavía se usan ábacos con diseños más modernos.

El Mecanismo de Anticitera es considerado la primera computadora analógica mecánica conocida. Fue creado para calcular las posiciones de los planetas y las estrellas. Se encontró en 1901 en un barco hundido cerca de la isla griega de Anticitera y se calcula que fue hecho alrededor del año 100 antes de Cristo. No se vieron inventos tan complejos hasta el siglo XIV, cuando aparecieron los relojes astronómicos mecánicos en Europa.

Mil años después, en el mundo islámico medieval, surgieron otros dispositivos mecánicos de cálculo. Algunos ejemplos son el Equatorium de Arzachel, el Astrolabio mecánico de Abu Rayhan al-Biruni y el Torquetum de Jabir ibn Aflah. Los ingenieros musulmanes también construyeron autómatas, que eran máquinas que podían realizar acciones, incluyendo algunos que podían "programarse" para tocar diferentes melodías. Además, matemáticos musulmanes como Alkindus hicieron grandes avances en la criptografía, que es el arte de escribir y descifrar códigos secretos.

En el siglo XVII, hubo un gran avance en las herramientas de cálculo. En 1623, Wilhelm Schickard diseñó una máquina de calcular, pero no pudo terminarla. Hacia 1640, el matemático francés Blaise Pascal construyó la primera máquina mecánica que podía sumar. Luego, en 1672, Gottfried Wilhelm Leibniz inventó su propia máquina, que terminó en 1695.

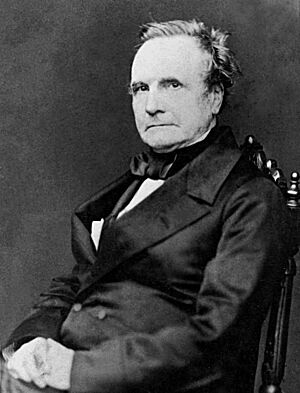

En 1837, Charles Babbage describió por primera vez su Máquina Analítica. Este diseño es considerado el primer concepto de una computadora moderna. La Máquina Analítica tendría memoria, una unidad para hacer cálculos y lógica, y la capacidad de entender un lenguaje de programación con repeticiones y decisiones. Aunque nunca se construyó, su diseño fue muy avanzado para su época.

Lógica Binaria y su Importancia

En 1703, Gottfried Wilhelm Leibniz desarrolló la lógica matemática usando el sistema de números binarios. En este sistema, los unos y los ceros pueden representar valores como "verdadero" o "falso", o estados como "encendido" o "apagado". Mucho tiempo después, en 1854, George Boole publicó su álgebra de Boole, un sistema completo que permitió modelar los procesos de cálculo de forma matemática.

Por esa época, se inventaron los primeros dispositivos mecánicos que funcionaban con patrones binarios. La Revolución Industrial impulsó la mecanización de muchas tareas, como el tejido. El telar de Joseph Marie Jacquard, inventado en 1801, usaba tarjetas perforadas: un agujero indicaba un uno binario y la ausencia de agujero, un cero. Aunque el telar de Jacquard no era una computadora, demostró que las máquinas podían controlarse con sistemas binarios.

El Nacimiento de la Ciencia de la Computación

Antes de la década de 1920, las "computadoras" eran personas, generalmente mujeres con conocimientos de cálculo, que realizaban operaciones matemáticas. Miles de estas personas trabajaban en empresas, gobiernos y centros de investigación.

Después de 1920, la expresión "máquina de computación" se empezó a usar para cualquier máquina que hiciera el trabajo de un "computador" humano. La tesis de Church-Turing explicó que un método matemático es "eficaz" si se puede describir como una lista de instrucciones que una persona podría seguir con lápiz y papel.

Las máquinas que calculaban con valores continuos se llamaban analógicas. Estas usaban mecanismos que representaban cantidades numéricas continuas, como el ángulo de giro de un eje. En contraste, las máquinas digitales podían representar un valor numérico y almacenar cada dígito por separado. Las primeras máquinas digitales usaban relés antes de que se inventaran dispositivos de memoria más rápidos.

La frase "máquina de computación" fue desapareciendo después de la década de 1940, y se empezó a usar solo "ordenador" o "computadora". Estas máquinas podían realizar los cálculos que antes hacían las personas.

Como los valores en las máquinas digitales no dependían de propiedades físicas (como en las analógicas), una computadora digital podía hacer cualquier cosa que pudiera describirse de forma "puramente mecánica". La Máquina de Turing, creada por Alan Turing, es un modelo teórico que ayuda a entender cómo funcionan estas máquinas.

El Surgimiento de una Nueva Disciplina

Los fundamentos matemáticos de la ciencia de la computación moderna fueron propuestos por Kurt Gödel en 1931 con su teorema de incompletitud. Este teorema mostró que hay límites a lo que se puede probar o refutar dentro de un sistema formal.

El año 1936 fue muy importante para la ciencia de la computación. Alan Turing y Alonzo Church presentaron, de forma independiente y luego juntos, una manera formal de describir un algoritmo, estableciendo los límites de lo que se puede calcular y un modelo "puramente mecánico" para la computación. Esto se conoce como la tesis de Church-Turing, que dice que cualquier cálculo posible puede ser realizado por un algoritmo en una computadora, siempre que haya suficiente tiempo y espacio de almacenamiento.

Turing también describió la máquina de Turing, un modelo teórico con una cinta infinita y un cabezal que puede leer y escribir. Aunque esta máquina nunca podría construirse, su modelo puede simular cómo funciona un algoritmo en una computadora moderna.

Alan Turing es tan importante que su nombre aparece en el Premio Turing (un premio muy prestigioso en computación) y la prueba de Turing (una prueba para la inteligencia artificial). Contribuyó mucho a que los británicos descifraran códigos secretos durante la Segunda Guerra Mundial.

En 1941, Konrad Zuse desarrolló la Z3, la primera computadora funcional controlada por un programa y que era "Turing-completa" (es decir, podía realizar cualquier cálculo que una máquina de Turing pudiera hacer). Zuse también creó la máquina de calcular S2, considerada la primera controlada por computadora. Fundó una de las primeras empresas de computación en 1941 y produjo la Z4, la primera computadora comercial. En 1946, diseñó Plankalkül, el primer lenguaje de programación de alto nivel.

En 1948, se construyó la primera computadora práctica que podía ejecutar programas almacenados, basada en el modelo de la máquina de Turing: el Manchester Baby. En 1950, el Laboratorio Nacional de Física de Gran Bretaña completó el Pilot ACE, una computadora programable más pequeña, también basada en las ideas de Turing.

Shannon y la Teoría de la Información

Antes y durante la década de 1930, los ingenieros eléctricos construían circuitos para resolver problemas matemáticos, pero a menudo lo hacían sin una base teórica sólida. Esto cambió con la tesis de maestría de Claude Elwood Shannon en 1937, "Un Análisis Simbólico de relé y circuitos de conmutación". Shannon se dio cuenta de que el álgebra de Boole podía usarse para organizar relés electromecánicos (usados en los teléfonos) para resolver problemas de lógica. Esta idea, de usar las propiedades de los interruptores eléctricos para crear lógica, es la base de todas las computadoras electrónicas digitales.

Shannon también fundó el campo de la teoría de la información con su artículo de 1948, "Una teoría matemática de la comunicación". En este trabajo, aplicó la teoría de la probabilidad para explicar cómo codificar la información de la mejor manera posible. Este trabajo es fundamental para áreas como la compresión de datos y la criptografía.

Wiener y la Cibernética

Basándose en experimentos con sistemas antiaéreos que interpretaban imágenes de radar, Norbert Wiener creó el término "cibernética", que viene de una palabra griega que significa "timonel" (la persona que dirige un barco). Publicó su libro "Cibernética" en 1948, que influyó en el desarrollo de la inteligencia artificial. Wiener también comparó el funcionamiento de las computadoras y los dispositivos de memoria con el análisis de las ondas cerebrales.

Un dato curioso es que el primer "fallo" (o "bug") real en una computadora fue causado por una polilla que se quedó atrapada entre los relés de la Harvard Mark II.

|

Véase también

En inglés: History of computer science Facts for Kids

En inglés: History of computer science Facts for Kids