Constante de Planck para niños

| Valor de h | Unidades |

|---|---|

| 6.626 070 15 × 10-34 | J⋅s |

| 4.135 667 696 × 10-15 | eV⋅s |

| Valor de ħ (h-barra) | Unidades |

| 1.054 571 817 × 10-34 | J⋅s |

| 6.582 119 569 × 10-16 | eV⋅s |

| Valor de hc | Unidades |

| 1.986 445 86 × 10-25 | J⋅m |

| 1.239 841 93 | eV⋅μm |

| Valor de ħc (h-barra) | Unidades |

| 3.161 526 49 × 10-26 | J⋅m |

| 0.197 326 9804 | eV⋅μm |

La constante de Planck es un número muy importante en la física que nos ayuda a entender cómo funciona el mundo a una escala muy, muy pequeña, como la de los átomos y las partículas. Lleva el nombre de Max Planck, un científico alemán que la descubrió.

Esta constante, que se representa con la letra h, nos dice que la energía no se puede dividir en cualquier cantidad. En cambio, la energía se presenta en "paquetes" o "cuantos" muy pequeños. Imagina que la energía es como una escalera: solo puedes estar en los escalones, no entre ellos. Cada escalón es un "cuanto" de energía.

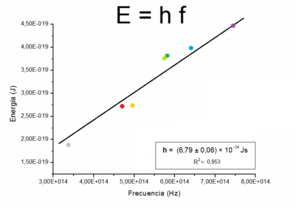

Planck descubrió que la energía de un "paquete" de luz, llamado fotón, está relacionada con su color (o frecuencia). Cuanto mayor es la frecuencia de la luz, más energía tiene cada fotón. Esto se expresa con la fórmula:

Donde E es la energía, h es la constante de Planck y f es la frecuencia.

También existe una versión de esta constante llamada "constante de Planck reducida", que se escribe ħ (h-barra). Es útil en cálculos más avanzados de la física cuántica.

«En este edificio enseñó

MAX PLANCK, el descubridor

del cuanto de acción h,

de 1889 a 1928»

Contenido

¿Cómo se descubrió la constante de Planck?

Un problema con la luz y el calor

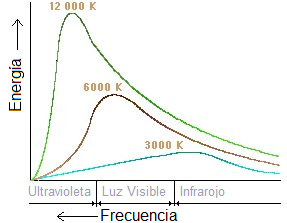

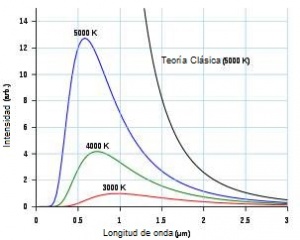

A finales del siglo XIX, los científicos estudiaban cómo los objetos calientes emiten luz y calor, un fenómeno llamado radiación térmica. Se interesaron especialmente en un concepto llamado "cuerpo negro". Un cuerpo negro es un objeto ideal que absorbe toda la luz y el calor que le llegan, y luego emite su propia radiación de una manera muy específica, dependiendo solo de su temperatura.

Los experimentos con cuerpos negros mostraron algo extraño. Las leyes de la física de ese momento no podían explicar por qué los objetos calientes no emitían una cantidad infinita de energía en ciertas frecuencias. Esto se conoció como la "catástrofe ultravioleta". Era como si la teoría predijera que un objeto caliente debería brillar con una energía ilimitada en el rango ultravioleta, lo cual no ocurría en la realidad.

Max Planck se propuso resolver este misterio. En 1900, tuvo una idea revolucionaria: la energía no se emitía ni se absorbía de forma continua, sino en pequeños "paquetes" o "cuantos". Al usar esta idea en sus cálculos, los resultados coincidieron perfectamente con lo que se observaba en los experimentos. Así fue como nació la constante de Planck, h, que representaba el tamaño de esos paquetes de energía.

El inicio de la física cuántica

El descubrimiento de Planck fue el punto de partida de una nueva rama de la física: la mecánica cuántica. Esta nueva forma de pensar cambió por completo nuestra comprensión del mundo a nivel atómico.

Otros científicos importantes, como Albert Einstein y Niels Bohr, también usaron la idea de los "cuantos" de energía para explicar otros fenómenos. Einstein, por ejemplo, explicó el efecto fotoeléctrico, donde la luz hace que los electrones salten de un metal. Bohr, por su parte, usó la constante de Planck para describir cómo los electrones se mueven alrededor del núcleo de un átomo en órbitas específicas.

¿Qué tan pequeña es la constante de Planck?

El valor de la constante de Planck es increíblemente pequeño: aproximadamente 6.63 × 10-34 J⋅s. Esto significa que los "paquetes" de energía son tan diminutos que no los notamos en nuestra vida diaria.

Por ejemplo, para calcular la energía de un solo fotón de luz verde, usamos la constante de Planck. La energía de ese fotón es minúscula. Solo cuando hablamos de una cantidad enorme de fotones, como los que nos llegan del Sol, la energía se vuelve significativa y la podemos percibir. Esto nos muestra que la constante de Planck es fundamental para entender el mundo a escala atómica, pero no es tan evidente en el mundo que vemos a simple vista.

La radiación del cuerpo negro

¿Qué es un cuerpo negro?

El concepto de "cuerpo negro" fue propuesto por Gustav Kirchhoff en 1862. Todos los objetos emiten radiación electromagnética (luz y calor) si su temperatura está por encima del cero absoluto. Esta radiación proviene de la energía térmica del objeto. Un cuerpo negro es un objeto ideal que absorbe toda la radiación que recibe y emite radiación de una forma muy específica, que solo depende de su temperatura.

Por ejemplo, el Sol tiene una temperatura de unos 5800 Kelvin y emite mucha luz visible. Nuestro cuerpo, con una temperatura de unos 37 grados Celsius, emite radiación infrarroja, que no podemos ver pero sí sentir como calor. La radiación que emite un cuerpo negro se llama "radiación del cuerpo negro". En la naturaleza no existe un cuerpo negro perfecto, pero este concepto es muy útil para entender la física.

El problema de la "catástrofe ultravioleta"

A finales del siglo XIX, la física clásica explicaba casi todo, pero tenía problemas con la radiación de los cuerpos negros. Una ley llamada Ley de Rayleigh-Jeans predecía que un cuerpo negro emitiría una cantidad infinita de energía en las frecuencias más altas (como la luz ultravioleta). Esto no tenía sentido, ya que los experimentos mostraban que la energía disminuía en esas frecuencias. Este error se llamó la "catástrofe ultravioleta".

Fue Max Planck quien resolvió este problema. Propuso que la energía se emitía y absorbía en "cuantos" (paquetes) de energía, cada uno con un valor de hf (constante de Planck por frecuencia). Esta idea revolucionaria no solo explicó la radiación del cuerpo negro, sino que también abrió la puerta a una nueva forma de entender el universo a nivel microscópico.

La ley de Planck

La ley de Planck describe cómo un cuerpo negro emite energía. Dice que la energía se intercambia en paquetes de energía hf. La fórmula es compleja, pero lo importante es que incluye la constante de Planck h, lo que demuestra que la energía se comporta de forma "cuantizada".

Esta ley ha sido confirmada por muchas observaciones, incluso en la astrofísica, y es fundamental para entender cómo se distribuye la energía en el espectro electromagnético.

El efecto fotoeléctrico

En 1887, Heinrich Rudolf Hertz descubrió que la luz ultravioleta podía ayudar a que una chispa eléctrica saltara entre dos puntos. Más tarde, Philipp Lenard demostró que esto ocurría porque la luz hacía que los electrones salieran de la superficie de un metal. Este fenómeno se llama efecto fotoeléctrico.

La teoría ondulatoria de la luz (que decía que la luz era solo una onda) no podía explicar este efecto por completo. Por ejemplo, no explicaba por qué la intensidad de la luz no afectaba la energía de los electrones liberados, sino su frecuencia.

Albert Einstein usó la idea de Planck de los "cuantos" de energía para explicar el efecto fotoeléctrico en 1905. Propuso que la luz no solo se comporta como una onda, sino también como partículas llamadas fotónes. La energía de cada fotón está relacionada con la frecuencia de la luz por la fórmula E = hf.

Según Einstein, cuando un fotón choca con un electrón en el metal, le transfiere su energía. Si el fotón tiene suficiente energía (es decir, si la luz tiene una frecuencia mínima), el electrón puede escapar del metal. La energía extra del fotón se convierte en la energía de movimiento del electrón. Esta explicación fue tan importante que Einstein ganó el Premio Nobel de Física en 1921 por ella. El efecto fotoeléctrico fue una prueba clave de que la luz tiene una naturaleza dual: se comporta como onda y como partícula.

Modelos atómicos: el modelo de Bohr

Niels Bohr, un físico danés, usó las ideas de Planck y Einstein para mejorar nuestra comprensión del átomo. En 1913, propuso su modelo atómico de Bohr, que describía el átomo como un núcleo central positivo rodeado por electrones que giran en órbitas específicas, como los planetas alrededor del Sol.

Este modelo fue un gran avance porque explicaba por qué los átomos emiten luz en colores muy específicos (espectros). Bohr propuso tres ideas clave:

Primer postulado

Los electrones se mueven en órbitas circulares alrededor del núcleo sin perder energía. Esto era una idea nueva, porque la física clásica decía que una carga en movimiento debería emitir energía y caer hacia el núcleo. Bohr postuló que esto no ocurría a nivel atómico.

Segundo postulado

No todas las órbitas están permitidas. Los electrones solo pueden estar en órbitas donde su "momento angular" (una medida de su movimiento de giro) sea un múltiplo entero de la constante de Planck reducida (ħ). Esto significa que las órbitas están "cuantizadas", es decir, solo pueden tener ciertos valores específicos.

Tercer postulado

Un electrón solo emite o absorbe energía cuando salta de una órbita permitida a otra. Si salta a una órbita de menor energía, emite un fotón con una energía igual a la diferencia entre las dos órbitas. Si salta a una órbita de mayor energía, absorbe un fotón. La energía de este fotón es E = hν, donde ν es la frecuencia del fotón.

El modelo de Bohr, aunque simple, fue muy exitoso para explicar el átomo de hidrógeno y demostró la importancia de la constante de Planck en la estructura atómica.

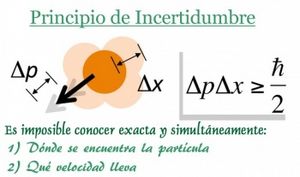

Principio de incertidumbre de Heisenberg

¿Qué es el principio de incertidumbre?

Werner Heisenberg, otro físico ganador del Premio Nobel, formuló el principio de incertidumbre en 1927. Este principio dice que es imposible conocer con total precisión y al mismo tiempo la posición y la cantidad de movimiento (masa por velocidad) de una partícula.

Esto no se debe a que nuestros instrumentos de medida sean imperfectos, sino a una característica fundamental de la naturaleza a escala cuántica. Cuanto más precisamente medimos la posición de una partícula, menos precisamente podemos conocer su cantidad de movimiento, y viceversa. El límite de esta incertidumbre está dado por una ecuación que incluye la constante de Planck:

Donde  es la incertidumbre en la posición y

es la incertidumbre en la posición y  es la incertidumbre en la cantidad de movimiento.

es la incertidumbre en la cantidad de movimiento.

También existe una relación similar para la energía y el tiempo: no podemos medir con total precisión la energía de un sistema y el tiempo durante el cual tiene esa energía al mismo tiempo.

Aplicación del principio de incertidumbre

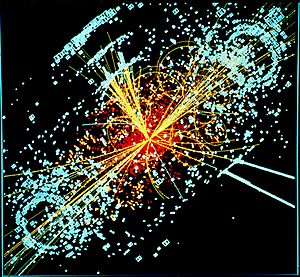

Este principio es muy importante en experimentos de física de partículas, como los que se realizan en el LHC del CERN. Allí, los científicos hacen chocar protónes a velocidades cercanas a la de la luz. El principio de incertidumbre nos dice que, aunque midamos la velocidad de un protón con mucha precisión, siempre habrá una incertidumbre en su posición.

Aunque la constante de Planck es muy pequeña, sus efectos no solo se ven en el mundo microscópico. Investigaciones recientes han demostrado que los efectos cuánticos, limitados por el principio de incertidumbre, también pueden observarse en objetos más grandes, lo que abre nuevas formas de entender la física.

Medidas experimentales de la constante de Planck

¿Cómo se mide la constante hoy en día?

Gracias a la tecnología moderna, la constante de Planck se puede medir con mucha precisión. Algunas de las formas más exactas de determinar su valor incluyen:

- El efecto Josephson, que ocurre en materiales superconductores.

- El efecto Hall cuántico, que mide la resistencia eléctrica en condiciones especiales.

- La balanza de Watt, un instrumento muy preciso que relaciona la energía mecánica con la energía eléctrica.

- Medidas relacionadas con el número de Avogadro, que es la cantidad de partículas en un mol de sustancia.

Aunque la constante de Planck se aplica a cosas muy pequeñas, las formas más precisas de medirla a menudo provienen de fenómenos que podemos observar a gran escala.

La constante de Planck en las unidades del SI

Desde el 20 de mayo de 2019, la constante de Planck tiene un valor fijo y sin incertidumbre en el (SI). Esto significa que su valor es exacto:

- Error al representar (Falta el ejecutable <code>texvc</code>. Véase math/README para configurarlo.): h = 6.626\ 070\ 15 \times10^{-34}\ \mbox{J}\cdot\mbox{s}

Este valor fijo es tan importante que ahora se usa para definir otras unidades fundamentales, como el kilogramo. Esto hace que las mediciones en física sean aún más precisas y universales.

Estimación de la constante de Planck con diodos LED

Aunque las mediciones más precisas requieren equipos avanzados, es posible estimar la constante de Planck en un laboratorio escolar o universitario usando diodos LED.

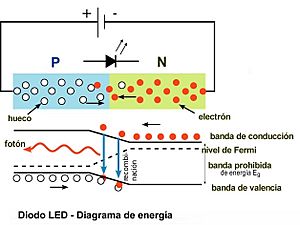

¿Cómo funcionan los LED?

Los diodos LED son pequeños componentes electrónicos que emiten luz cuando pasa una corriente eléctrica a través de ellos. Están hechos de materiales semiconductores con dos zonas diferentes: una "zona P" (con "huecos" o falta de electrones) y una "zona N" (con exceso de electrones). Cuando estas zonas se unen, se forma una "unión PN".

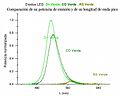

Cuando conectamos un LED a una batería de la manera correcta (polarización directa), los electrones de la zona N se mueven hacia la zona P y se combinan con los "huecos". En este proceso de "recombinación", los electrones pierden energía y la liberan en forma de fotónes de luz. El color de la luz que emite un LED depende del tipo de material semiconductor del que está hecho.

Para que un LED empiece a emitir luz, necesita una cierta cantidad de voltaje, llamada "tensión de encendido" (V0). Esta tensión está relacionada con la energía que los electrones necesitan para saltar y emitir un fotón. La energía de ese fotón es igual a hf.

El experimento con LED

Para estimar la constante de Planck con LED, se mide la tensión de encendido (V0) para varios LED de diferentes colores (y por lo tanto, diferentes frecuencias de luz).

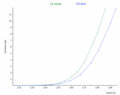

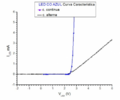

1. Medir la longitud de onda: Se usa un analizador de espectros para determinar la longitud de onda (y así la frecuencia) de la luz que emite cada LED. 2. Medir la tensión de encendido: Se conecta cada LED a un circuito y se aumenta el voltaje lentamente hasta que el LED empieza a brillar. Ese voltaje es la tensión de encendido (V0). Se puede hacer con corriente continua o corriente alterna. 3. Calcular la constante de Planck: Sabemos que la energía que el electrón necesita para emitir un fotón es aproximadamente igual a la carga del electrón (e) multiplicada por la tensión de encendido (V0), es decir, e V0. También sabemos que la energía del fotón es hf. Por lo tanto, podemos decir que:

Error al representar (Falta el ejecutable <code>texvc</code>. Véase math/README para configurarlo.): e V_0 \approx hf

Si graficamos los valores de e V0 (en el eje vertical) contra la frecuencia f (en el eje horizontal) para todos los LED, obtendremos una línea recta. La pendiente de esa línea recta será una estimación de la constante de Planck h.

Este método, aunque no es tan preciso como los usados en laboratorios de investigación, es una excelente manera de entender los principios de la mecánica cuántica y cómo se relaciona la constante de Planck con la emisión de luz en objetos cotidianos como los LED.

Galería de imágenes

-

Curva característica midiendo con el LED Azul y el LED verde, ambos de CO utilizando el primer procediemiento (circuito de CC).

-

Resultados del segundo procedimiento (circuito de CA) a) Curva característica del LED rojo, b) Representación temporal de la corriente a través del LED (I), y de la tensión de alimentación (V)

Véase también

En inglés: Planck constant Facts for Kids

En inglés: Planck constant Facts for Kids