Computación distribuida para niños

La computación distribuida es una forma de resolver problemas muy grandes usando muchas computadoras que trabajan juntas. Imagina que tienes una tarea enorme, como calcular algo muy complicado o procesar muchísima información. En lugar de que una sola computadora intente hacerlo todo, la computación distribuida divide esa tarea en partes más pequeñas y las envía a diferentes computadoras conectadas en una red. Cada computadora resuelve su parte y luego envía el resultado de vuelta.

Este sistema es como un gran equipo de trabajo donde cada miembro (computadora) hace una parte del proyecto. Así, se pueden lograr cálculos que serían imposibles para una sola máquina, incluso para las más potentes, y a menudo a un costo mucho menor que el de una supercomputadora.

Una de las grandes ventajas de la computación distribuida es que las tareas se pueden enviar al lugar donde se puedan hacer de la manera más eficiente. Por ejemplo, en una empresa, cada oficina podría manejar sus propios datos y luego compartir los resultados con el resto de la organización. Esto también ayuda a que los equipos funcionen mejor y a que el trabajo se reparta de forma equilibrada, especialmente en aplicaciones donde ninguna computadora por sí sola podría hacer todo el procesamiento.

Contenido

¿Cómo funciona la computación distribuida?

Desde que surgieron las primeras computadoras modernas, la forma de trabajar era que una sola máquina hacía todo el trabajo. Pero a partir de los años 80, dos cosas importantes cambiaron el juego:

- Las computadoras se hicieron más pequeñas, potentes y baratas.

- Aparecieron las redes de computadoras rápidas, que podían conectar cientos de máquinas.

Estos avances permitieron que las computadoras dejaran de trabajar solas y empezaran a formar sistemas distribuidos. En estos sistemas, las partes de un programa o los equipos están en diferentes computadoras, pero todas están conectadas por una red y trabajan como si fueran un solo sistema.

Un sistema distribuido tiene algunas características clave:

- Trabajo al mismo tiempo: Varias partes del sistema pueden estar haciendo cosas a la vez en diferentes computadoras.

- Sin un reloj central: Las computadoras no tienen un reloj único que las coordine a todas. Necesitan otras formas de ponerse de acuerdo.

- Resistencia a fallos: Si una computadora o una conexión falla, no todo el sistema se cae. Las otras partes pueden seguir funcionando.

Historia de la computación distribuida

La idea de que las computadoras se enviaran mensajes entre sí nació a finales de los años 60. Aunque todavía no existían las redes de computadoras como las conocemos hoy, se pensó en organizar los programas de las computadoras como un grupo de "procesos" que se comunicaban, cada uno con una tarea específica.

En los años 70, surgieron las primeras redes de área local (LAN), como Ethernet. Esto hizo que se desarrollaran muchos programas y formas de trabajar con sistemas distribuidos. Cuando el costo de estas redes bajó, se popularizó el modelo de cliente-servidor.

A finales de los años 60, también se creó ARPANET, que fue la base de Internet hasta 1990. A principios de los 70, el correo electrónico de ARPANET se convirtió en una de las primeras aplicaciones distribuidas a gran escala.

Desde entonces, se ha investigado mucho sobre cómo hacer que los algoritmos (las instrucciones para las computadoras) funcionen bien en sistemas distribuidos, y este campo ha crecido mucho.

¿Qué tan rápido puede ser el trabajo en paralelo?

Una pregunta importante en la computación distribuida es qué tan eficiente puede ser dividir una tarea para que muchas computadoras la hagan al mismo tiempo. En 1967, un científico llamado Gene Amdahl explicó que si una parte de un programa no se puede dividir para que se haga en paralelo, esa parte limitará la velocidad total que se puede ganar al usar muchas computadoras.

Esto significa que, aunque tengas muchísimas computadoras, si una parte del trabajo tiene que hacerse sí o sí de forma secuencial (una cosa después de otra), esa parte será el "cuello de botella" y no podrás acelerar el proceso más allá de cierto punto. Esta idea, conocida como la Ley de Amdahl, es muy importante al diseñar programas para sistemas distribuidos.

Computación paralela vs. distribuida

Aunque suenan parecidas, la computación paralela y la distribuida tienen diferencias importantes en cómo se organizan y qué buscan:

- Computación paralela: Las computadoras suelen compartir una misma memoria. Esto permite que se comuniquen muy rápido. Su objetivo principal es hacer las cosas lo más rápido posible.

- Computación distribuida: Cada computadora tiene su propia memoria y se comunican enviándose mensajes. Su objetivo principal es poder crecer (añadir más computadoras fácilmente) y seguir funcionando aunque algo falle.

Piensa en la computación paralela como un equipo de personas que trabajan en la misma mesa, compartiendo los mismos papeles y herramientas. La computación distribuida es como un equipo de personas que trabajan en diferentes oficinas, cada una con sus propios papeles, y se envían correos electrónicos para comunicarse.

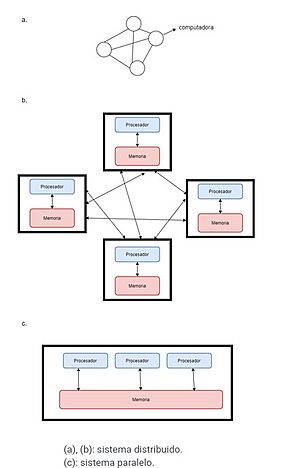

La imagen de la derecha te ayuda a entenderlo:

- Las figuras (a) y (b) muestran un sistema distribuido: computadoras separadas que se conectan por una red y se envían mensajes.

- La figura (c) muestra un sistema paralelo: varios procesadores que acceden a una misma memoria compartida.

Tipos de arquitecturas

En la computación distribuida, hay diferentes formas de organizar las computadoras y cómo se comunican. Aquí te explicamos algunas de las más comunes:

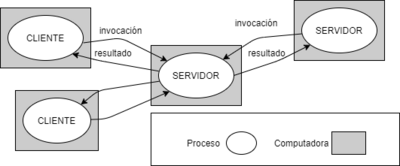

Cliente-servidor

En este modelo, hay computadoras que son "clientes" y otras que son "servidores". Los clientes piden información o servicios a los servidores, y los servidores les responden. Por ejemplo, cuando usas un navegador web (el cliente) para ver una página, le pides esa página a un servidor web, y este te la envía.

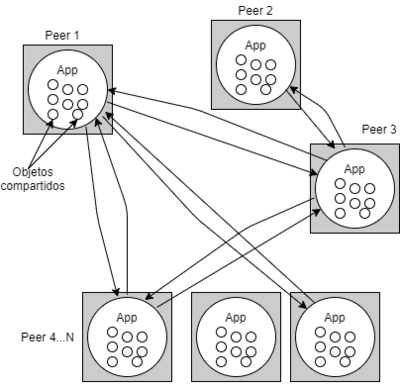

Peer-to-peer (P2P)

En este tipo de sistema, todas las computadoras son "iguales" (peers). No hay un servidor central que controle todo. Todas las computadoras pueden compartir recursos y servicios directamente entre sí. Un ejemplo famoso es BitTorrent, donde los usuarios comparten archivos directamente entre sus computadoras.

Arquitectura de Capas

Este modelo organiza el sistema en diferentes niveles o "capas". Cada capa ofrece servicios a la capa de arriba y usa los servicios de la capa de abajo, sin necesidad de saber cómo funcionan los detalles internos de las otras capas. Esto ayuda a que los sistemas complejos sean más fáciles de diseñar y mantener.

Una estructura común tiene cuatro capas:

- Capa de aplicaciones y servicios: Lo que los usuarios ven y usan (por ejemplo, una aplicación de chat).

- Capa de middleware: Un software que ayuda a que las diferentes partes del sistema distribuido se comuniquen y parezca que todo es un solo sistema.

- Capa de sistema operativo: El programa principal que controla la computadora.

- Capa de hardware de redes y computadoras: Las computadoras y las conexiones físicas.

Aplicaciones y ejemplos

La computación distribuida se usa en muchísimos lugares en nuestra vida diaria. La mayoría de los sistemas que usamos son cliente-servidor, pero los sistemas peer-to-peer también son cada vez más populares. Aquí tienes algunos ejemplos:

- World Wide Web: Cuando navegas por Internet, tu computadora (cliente) se conecta a servidores de todo el mundo para obtener páginas web, imágenes y videos.

- Servidores de archivos en red: En una oficina o escuela, puede haber una computadora central (servidor de archivos) donde se guardan todos los documentos, y las demás computadoras pueden acceder a ellos.

- Redes bancarias: Cuando sacas dinero de un cajero automático o haces una transferencia, tu banco se comunica con otros bancos y sistemas distribuidos para procesar la transacción.

- Redes peer-to-peer: Se usan para compartir archivos o para sistemas como las criptomonedas, donde muchas computadoras trabajan juntas para verificar transacciones.

- Sistemas de control de procesos: En fábricas, se usan redes de computadoras para controlar la producción y el mantenimiento de las máquinas.

- Redes de sensores: Pequeños dispositivos con sensores que se comunican de forma inalámbrica para recolectar datos, por ejemplo, para monitorear el clima o la calidad del aire.

- Grid Computing: Es una forma de computación distribuida que conecta muchas computadoras (a veces millones en todo el mundo) para trabajar en proyectos científicos o de investigación muy grandes y complejos.

- Clústeres: Un clúster es un grupo de dos o más computadoras que se conectan para trabajar juntas en una misma tarea. Cada computadora en un clúster se llama "nodo". Esto permite que trabajen como un solo sistema para procesar y analizar datos más rápido. IBM empezó a usar clústeres en los años 60 para mejorar la eficiencia de sus procesadores.

Ventajas y desventajas

Ventajas

- Trabajo en diferentes lugares: Es ideal para situaciones donde las computadoras están en distintos lugares geográficos, como una red bancaria o Internet.

- Mayor velocidad: Al dividir un problema en partes y que muchas computadoras trabajen al mismo tiempo, se pueden resolver problemas mucho más rápido.

- Compartir recursos: Permite que las computadoras compartan impresoras, espacio de almacenamiento o incluso su capacidad de procesamiento cuando no la están usando.

- Resistencia a fallos: Si una parte del sistema falla, el resto puede seguir funcionando. Esto hace que el sistema sea más confiable.

- Modularidad: Las partes del sistema (como cliente y servidor) son independientes y se pueden mejorar o reemplazar sin afectar a las demás.

- Portabilidad: Las aplicaciones pueden funcionar en diferentes tipos de dispositivos, desde grandes servidores hasta computadoras portátiles.

Desventajas

- Escalabilidad: Diseñar un sistema que pueda crecer fácilmente a medida que aumenta la demanda puede ser un reto.

- Diversidad de equipos: Las computadoras y las redes pueden ser muy diferentes entre sí, lo que complica la comunicación.

- Gestión de recursos: Es difícil saber dónde están todos los recursos y cómo dirigirlos de la mejor manera.

- Seguridad y privacidad: Como se maneja información importante, se necesitan medidas de seguridad muy fuertes para proteger los datos.

- Transparencia: Hacer que un sistema distribuido parezca una sola computadora para el usuario, ocultando su complejidad, es un desafío.

- Apertura: Diseñar el sistema para que pueda conectarse fácilmente con otros sistemas usando reglas estándar.

- Sincronización: Coordinar miles de computadoras para que trabajen de forma consistente es uno de los mayores problemas.

- Bloqueos y condiciones de carrera: A veces, diferentes partes del sistema pueden intentar acceder al mismo recurso al mismo tiempo, causando problemas o bloqueos.

Galería de imágenes

Véase también

En inglés: Distributed computing Facts for Kids

En inglés: Distributed computing Facts for Kids