Información mutua para niños

La información mutua es una idea interesante que nos ayuda a entender cuánto se relacionan dos cosas diferentes. Imagina que tienes dos grupos de datos o eventos, como si fueran dos "variables aleatorias". La información mutua mide qué tanto saber sobre una de esas variables te ayuda a entender o predecir la otra.

Por ejemplo, si sabes que está lloviendo (una variable), es muy probable que la calle esté mojada (la otra variable). Hay mucha información mutua entre "lluvia" y "calle mojada". Pero si sabes que un amigo tiene un perro (una variable), eso no te dice nada sobre el color de su camiseta (la otra variable). En este caso, la información mutua sería cero.

Esta idea es más flexible que otras formas de medir relaciones, como la correlación, porque no solo funciona con números o con relaciones directas. Puede usarse para cualquier tipo de datos y para relaciones más complejas.

El concepto fue introducido por un científico llamado Claude Shannon en su importante trabajo sobre la comunicación. Más tarde, otro científico, Robert Fano, le dio el nombre de "información mutua".

Contenido

¿Qué es la Información Mutua?

La información mutua nos dice cuánta "incertidumbre" (o sorpresa) se reduce sobre una variable cuando conocemos el valor de otra. Si dos variables están muy relacionadas, conocer una nos da mucha información sobre la otra, y nuestra incertidumbre disminuye mucho. Si no están relacionadas, conocer una no nos ayuda en nada con la otra.

¿Cómo se mide la información mutua?

La información mutua se mide usando una unidad llamada bit. Un bit es la cantidad de información que se necesita para decidir entre dos opciones igualmente probables, como un "sí" o un "no".

La forma de calcular la información mutua implica usar logaritmos y las probabilidades de que ocurran ciertos eventos. Aunque las fórmulas pueden parecer complicadas, la idea principal es comparar la probabilidad de que dos cosas ocurran juntas con la probabilidad de que ocurran por separado. Si ocurren juntas más a menudo de lo que esperaríamos por casualidad, entonces hay información mutua.

Una propiedad importante es que la información mutua entre dos variables, digamos X e Y, es la misma que la información mutua entre Y y X. Es decir, saber de X te da la misma cantidad de información sobre Y que saber de Y te da sobre X.

Información Mutua Promedio

La información mutua promedio (o media) es una medida general de cuánta información comparten dos variables aleatorias en promedio. Piensa en ella como el promedio de toda la información mutua que se produce entre los diferentes valores que pueden tomar esas variables.

¿Qué significa la información mutua promedio?

Intuitivamente, la información mutua promedio nos dice cuánto "conocimiento" comparten dos variables. Mide cuánto el saber sobre una variable reduce nuestra sorpresa o incertidumbre sobre la otra.

- Si no hay relación: Si dos variables, como el color de tu camiseta y el clima en otro país, no tienen ninguna relación, entonces conocer una no te da ninguna información sobre la otra. En este caso, su información mutua promedio es cero.

- Si hay una relación perfecta: Si dos variables son exactamente iguales (por ejemplo, la temperatura en grados Celsius y la temperatura en grados Celsius, ¡son la misma cosa!), entonces conocer una te dice todo sobre la otra. La información mutua promedio sería muy alta, igual a la cantidad de información que tiene la variable por sí sola.

La información mutua promedio es una excelente forma de saber si dos variables dependen la una de la otra. Si la información mutua promedio es cero, significa que las variables son completamente independientes. Si es mayor que cero, significa que hay algún tipo de dependencia.

Propiedades de la Información Mutua Promedio

La información mutua promedio tiene algunas características importantes:

- Siempre es un número positivo o cero. Nunca puede ser negativa.

- Su valor máximo está limitado por la cantidad de información que tiene cada variable por separado.

- Es simétrica: la información mutua promedio de X con Y es la misma que la de Y con X.

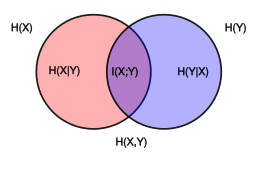

Relación con la Entropía

La información mutua promedio está muy relacionada con un concepto llamado entropía. En el mundo de la información, la entropía mide la cantidad de incertidumbre o la "sorpresa" que tiene una variable por sí sola. Cuanto más impredecible es algo, mayor es su entropía.

La información mutua promedio se puede calcular usando la entropía. De hecho, la información mutua promedio entre dos variables es igual a la suma de sus entropías individuales, menos la entropía de ambas variables consideradas juntas.

También podemos ver que la información mutua de una variable consigo misma es igual a su propia entropía. Esto tiene sentido, porque si conoces una variable, ¡sabes todo sobre ella misma!

Véase también

En inglés: Mutual information Facts for Kids

En inglés: Mutual information Facts for Kids